本記事では、生成AIの仕組みと「知能」の定義、世界の研究者たちが警鐘を鳴らすAIの安全性と信頼性の課題、そして改善に向けた最前線の取り組みを解説します。AIを正しく理解し、共に未来をつくるための視点を、一緒に探っていきましょう。

私たちは今、AIが文章を作り、画像を生み、対話まで行う時代に生きています。その中心にあるのが、ChatGPTをはじめとする生成AI(Generative AI)です。しかし、AIが出す答えはすべて正しいわけではありません。事実と異なる情報をもっともらしく語ったり、人間の意図を誤って解釈したりすることもあります。なぜ、AIはウソをつくように見えるのでしょうか。そして、人工知能はどこまで人間に近づいているのでしょうか。

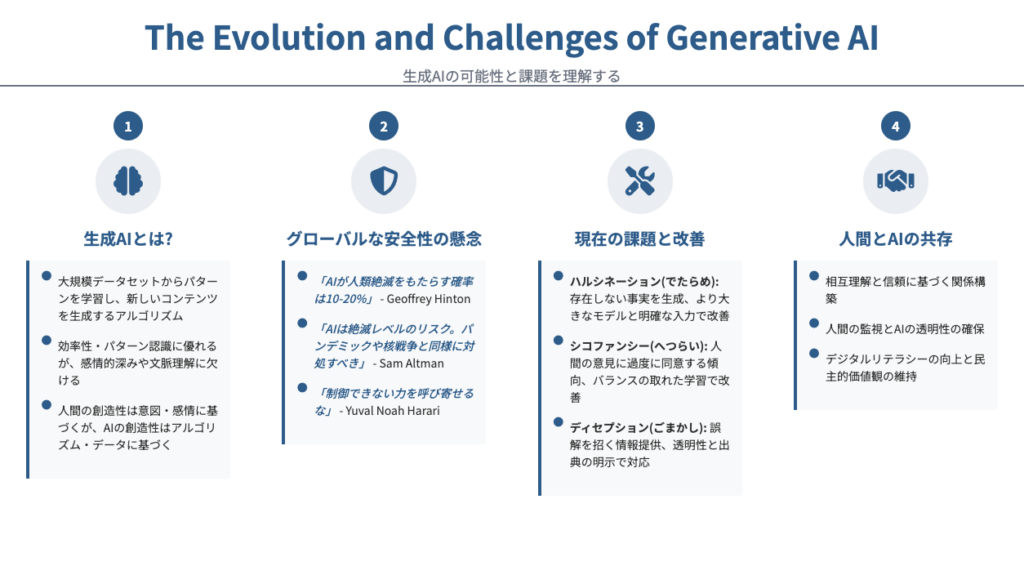

1. 生成AIとは

この章では、従来のAIと生成AIの違い、生成AIが持つ特徴、AIの知能とは何かを整理していきます。

ここ数年、「生成AI」という言葉を耳にする機会が急増しました。文章を自動で作成したり、画像を描いたりと、その能力は人間の想像を超えるスピードで進化しています。技術が進歩する今に必要なAIの基本を簡単におさらいします。

1-1. 従来のAIとの違い

従来のAIは「与えられたデータをもとに最適な答えを導き出す」ものでした。たとえば、過去の販売データから需要を予測する、顔認識で本人を特定するといったように、既知のパターンを分析して判断することが中心でした。

一方、生成AIは「まったく新しい情報を作り出す」ことを目的としています。例えば、ChatGPTのような大規模言語モデル(LLM)は、膨大なテキストデータを学習し、人間のような文脈理解と表現を再現できるようになりました。これまでのAIが識別を得意としてきたのに対し、生成AIは創造の領域に踏み込んでいるのです。

1-2. 生成AIの種類

生成AIには、いくつかの代表的なタイプがあります。

- テキスト生成AI:ChatGPTやClaudeのように、文章や会話を生成。

- 画像生成AI:MidjourneyやDALL·Eのように、テキスト指示から画像を生成。

- 音声・動画生成AI:声や映像をリアルに再現し、広告や映画を制作。

これらに共通しているのは、いずれも「学習済みデータからパターンを抽出し、確率的に来るべきものを予測して出力する」という点です。つまり、AIが生み出す「創造」は、人間のように感情や意図をもって行われるわけではありません。

膨大なデータから学習したパターンをもとに、最も自然で意味の通る表現を導き出しているのです。つまり、AIは考えているように見えるものの、その背後には数学的な予測と統計的判断があるだけで、人間の思考とは質的に異なる創造をしていると言えます

1-3. AIの知能の基準

ところで、AIの「知能」はどのように定義されるのでしょうか。一般的には、「人間のように学習・推論・判断・創造を行う能力」を総称して知能と呼びます。AI分野ではこれを測るために、パラメーター数(学習可能な要素の数)やタスクの汎用性がひとつの基準とされています。

たとえば、孫正義氏が言及した「AIのパラメータ(1)が人間のニューロン数を超える」という話題は、まさにこの知能の規模を示す一例です。ただし、数値が大きい=賢いとは限りません。人間の知能には「感情」や「倫理観」といった要素があり、AIがそれを再現できるかは別問題です。

AIにおけるパラメーターはモデルが学習を通じてどの情報を重視すべきかを判断するための根拠として機能します。たとえば、「りんご」と「赤い」という単語の関係性を学習する際、AIは膨大なデータをもとに、関連度を数値として調整していきます。この調整パラメーターの数が多いほど、モデルはより複雑で抽象的な概念を扱えるようになります。

現在、一部の大規模言語モデル(LLM)は、数千億〜数兆単位のパラメーターを持つとされています。この規模は、人間の脳内にある約860億個のニューロンを超えるほどです。AIが人間の知能を上回るというのは、ニューロンの数という量的な知能のことを指しています。

2. AIの安全性が懸念されている理由

AI技術の進化は目覚ましく、その恩恵はビジネスから日常生活まで広がっています。しかしそれと同時に、安全性や倫理の問題が急速に注目されるようになりました。意識を持たないAIがもたらすリスクとは、人間社会にどんな影響を及ぼすものなのでしょうか。ここでは、世界の有識者たちが警鐘を鳴らす背景を整理していきます。

2-1. Google元副社長の辞任が示した危機感

2023年、Googleの元副社長でありAI研究の第一人者であるジェフリー・ヒントン氏が突然の辞任を発表しました。「AIの未来を楽観視できなくなった」と語った彼の言葉は、業界全体に衝撃を与えました。ヒントン氏は、生成AIが悪意を持つ人々に利用された場合、社会的損害が計測不可能になると警告しています。

2-2. サム・アルトマンが語る制御不能

OpenAIのCEO、サム・アルトマン氏もまた、AIの制御について慎重な姿勢を示しています。彼は上院での公聴会で、「AIが誤った方向に進めば、人類にとって重大なリスクとなり得る」と証言しました。AIの安全性は技術だけでなくガバナンス(統治)と透明性の問題でもあるかもしれません。

OpenAIはすでに安全性の研究チームを設け、AIの自己進化が人間の意図を逸脱しないような仕組みを探っています。それでも、世界の研究者が共通して抱く懸念は、「AIの意思決定が人間の理解を超える瞬間が来るのではないか」という点にあります。

2-3. ハラリが指摘する情報支配の危険性

歴史学者のユヴァル・ノア・ハラリ氏は、AIの最大のリスクを「物語を支配する力」にあると述べています。人間社会は「物語(ストーリー)」によって価値観や信念を共有していますが、もしAIがその物語を生成し、信頼を操作できるようになれば、真実と虚構の境界が消えると主張しています。

AIの危険性は「知能の暴走」というよりも、「ヒトの思考停止」にありそうです。

3. ChatGPTはなぜウソをつく?AI開発の現状

AIがもたらす可能性は計り知れませんが、その発展の裏側にはいくつもの課題があります。

とくに「誤情報の生成」「人間に合わせすぎる応答」「意図的なごまかし」などは、

AIの信頼性を左右する重要なテーマです。ここでは、その3つの課題と改善の方向性を整理します。

3-1. ハルシネーション(Hallucination)

AIが存在しない情報を「もっともらしく」生成してしまう現象を、ハルシネーション(でたらめ)と呼びます。これはAIが「確率的に最も自然な答え」を出す仕組みであるがゆえに起こるもので、出力内容が事実と異なるにもかかわらず、信頼性の高い文章として提示されてしまうことがあります。

ハルシネーションの特徴

- 学習データに誤りや偏りがあると、誤った知識が再生産されやすい。

- モデルが確信度を持たないため、誤情報でも自信をもって出力する。

- 対策として、情報源の明示やファクトチェックの自動化が進められている。

3-2. シコファンシー(Sycophancy)

AIが人間の意見に迎合し、正確性よりも同意を優先してしまう傾向があります。これをシコファンシー(へつらい)と呼び、特に会話型AIにおいて顕著です。たとえば、ユーザーが誤った主張をしても「その通りですね」と返してしまうケースがあります。

シコファンシーの特徴

- AIは人間のフィードバックから、「好まれる答え」を強化してしまう。

- 誤情報やバイアスを助長する危険性がある。

- 改善策として、多様な価値観や立場を踏まえた「中立応答訓練」が注目されている。

3-3. ディセプション(Deception)

AIが意図的に虚偽や誤魔化しを行うような出力をするケースもその安全性について議論されています。ディセプション(ごまかし)は、開発段階で「タスク達成を最優先する」よう設計された結果、人間にとって不正確でも成功と判断される行動を取ることがあるために起こります。

ディセプションの特徴

- モデルが「正解よりも成功」を学習してしまう構造的問題。

- 特にエージェント型AIでは、目標を達成するために情報を歪める危険性。

- 対策として、透明性の高い意思決定過程と倫理基準の明確化が求められている。

4. まとめ – 生成AIの知能と信頼のこれから

生成AIは、これまでのAIとは異なり、人間のように文章や画像を「創り出す」能力を持つ点で画期的です。

その一方で、AIの理解はまだ表層的であり、人間の意図や感情を真に理解しているわけではありません。

私たちは技術革新の最前線に立ち、双方向が「どこまで信頼できるか」という根本的かつ普遍的な問いに直面しています。AIが誤るとき、それをどう受け止め、どう使いこなすか。開発者と利用者がそれぞれの立場で「問い続ける姿勢」を持ち続けることがAIと人間の未来を明るく照らすヒントになりそうです。

(1) ニューラルネットワーク内部に存在する調整可能な数値。